La moindre modification sur un site web peut entraîner des variations mesurables dans le comportement des utilisateurs. Chez Google, des expérimentations menées à grande échelle révèlent que des ajustements mineurs, parfois imperceptibles, suffisent à influer sur des millions de parcours. Pourtant, l’efficacité réelle de ces changements ne se juge qu’à travers des comparaisons structurées, où chaque détail compte.

La mise en œuvre de ces méthodes repose sur des protocoles rigoureux, des outils spécialisés et un suivi précis des indicateurs. Des règles strictes encadrent le déroulement et l’interprétation des résultats, tandis que des solutions automatisées facilitent l’accès à des analyses fiables et exploitables.

Comprendre le test A/B : principes et enjeux pour l’expérience utilisateur

Sur une page web, rien n’est anodin. Le test A/B, aussi appelé A/B testing, s’est imposé comme la méthode de référence pour mesurer l’effet réel d’un changement sur l’expérience utilisateur. Chez Google, la recette est simple : deux versions différentes d’une page sont présentées en parallèle à des groupes d’utilisateurs distincts. Ce protocole permet de comparer objectivement les résultats et d’identifier la variante qui fait mouche.

Le test A/B intervient dès qu’il s’agit d’optimiser l’expérience utilisateur. Changer la couleur d’un bouton, retravailler une accroche, déplacer un formulaire : tout est prétexte à l’expérimentation. Ces essais génèrent des données précieuses pour mesurer le taux de conversion ou le taux de rebond dans le détail. À grande échelle, Google affine ses propres services avec ces méthodes, tout en équipant les professionnels du marketing digital d’outils d’analyse avancés.

L’intérêt de la démarche ? Prendre des décisions sur la base de preuves, non d’intuitions. Les équipes marketing, UX et produit s’appuient sur ces tests pour ajuster leurs sites, repenser les pages, et renforcer l’engagement des utilisateurs.

Voici les apports concrets du test A/B sur l’expérience utilisateur :

- Évaluer l’effet réel de chaque modification sur le comportement des utilisateurs

- Améliorer les taux de conversion sans dégrader l’expérience globale

- Fonder chaque choix sur des données solides et vérifiées

Tester, recommencer, analyser : ces trois réflexes rythment désormais l’optimisation de l’expérience utilisateur sur les sites à fort trafic. Les résultats sont transparents, segmentés, exploitables, bien loin des suppositions d’autrefois.

Quels sont les mécanismes derrière un test A/B réussi ?

Tout démarre par une hypothèse claire, mesurable, basée sur l’analyse des comportements existants. Google recommande de cibler une seule variable à la fois : un titre, un bouton, une image. Cela garantit que les résultats reflètent bien l’impact de cette variation précise.

La taille de l’échantillon joue un rôle clé. Un groupe trop restreint fausse la fiabilité des résultats, alors qu’un échantillon trop vaste ralentit le processus. Les outils comme Google Optimize proposent des calculateurs spécifiques pour ajuster la taille du test selon le trafic et les objectifs. Chaque expérimentation doit durer suffisamment longtemps pour collecter des données robustes et obtenir des résultats statistiquement significatifs.

Les étapes structurantes

Un test A/B solide suit toujours un enchaînement précis, que voici :

- Définition précise de l’hypothèse à valider

- Choix d’une variable unique à modifier

- Répartition aléatoire du trafic entre les différentes versions

- Collecte et analyse approfondie des données

- Validation des enseignements via des méthodes statistiques fiables

Les tests multivariés et le split URL testing ouvrent la porte à des scénarios plus ambitieux, où plusieurs éléments ou pages entières sont testés en parallèle. Ces techniques avancées nécessitent une vraie maîtrise des outils et une lecture attentive des résultats. L’analyse ne se limite pas à comparer des taux de conversion : elle s’attarde aussi sur les différents segments d’audience, et sur les comportements observés sur le long terme. Réussir un test A/B, c’est savoir exploiter chaque résultat pour affiner la prochaine itération.

Étapes clés et bonnes pratiques pour mener vos propres expériences

Avant de lancer un test A/B, il s’agit de formuler une question stratégique. Quelle action souhaitez-vous améliorer sur votre site ? Repérez le point qui freine : formulaire trop long, bouton invisible, manque de preuve sociale. Chaque détail a son influence sur le taux de conversion. Pour avancer, structurez la démarche étape par étape.

Planification et préparation

Commencez par identifier précisément l’élément à optimiser, puis déterminez l’indicateur qui servira de boussole pendant le test.

- Sélectionnez la page ou l’élément à travailler : page d’atterrissage, bouton d’appel à l’action, navigation principale…

- Choisissez l’indicateur à suivre : taux de clics (CTR), taux de conversion, complétion de formulaire…

Une hypothèse bien rédigée pose les fondations du test. Modifiez un seul paramètre à la fois. Essayez un bouton plus visible, reformulez un texte d’action, simplifiez un formulaire : chaque alternative doit répondre à une intention claire et mesurable.

Mise en œuvre et suivi

Une fois la préparation achevée, il reste à répartir le trafic et à observer l’évolution sur la durée.

- Distribuez le trafic équitablement entre les différentes versions à tester

- Collectez les données patiemment ; le volume de trafic influera sur la durée du test

L’interprétation des résultats demande méthode et objectivité. Analysez l’effet concret de chaque modification sur le taux de conversion, faites le lien entre les changements et les évolutions de comportement. Chaque essai affine la stratégie globale d’optimisation. Pour éviter tout biais, il est parfois judicieux de faire appel à un consultant externe qui posera un regard neuf sur les données.

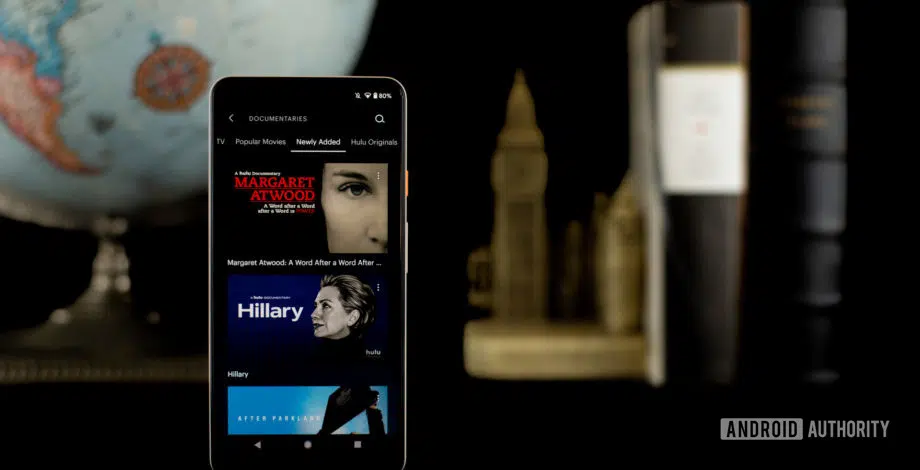

Panorama des outils Google et alternatives pour optimiser vos tests A/B

Le Google Optimize a longtemps été la porte d’entrée la plus naturelle pour le A/B testing. Parfaitement intégré à Google Analytics, il a permis de mettre en place des tests sur différentes versions d’une page web, tout en suivant de près les KPI majeurs : taux de conversion, taux de rebond, comportement utilisateur. Mais la disparition annoncée de Google Optimize a redistribué les cartes. Un nouvel élan anime le marché.

De nombreuses alternatives émergent, chacune développant sa vision du testing et de la personnalisation. Voici un aperçu des solutions les plus en vue :

- AB Tasty : interface intuitive, fonctionnalités avancées pour tests multivariés et personnalisation dynamique. L’outil se distingue par la finesse de ses segments utilisateurs.

- Kameleoon : apprécié pour sa connexion directe avec les CMS et sa gestion de campagnes de personnalisation à grande échelle.

- VWO Testing (Visual Website Optimizer) : reconnu pour la robustesse de ses analyses statistiques et sa capacité à gérer des tests complexes, avec un tableau de bord complet pour piloter chaque indicateur.

- Optimizely : pionnier historique, il mise sur l’intégration poussée avec les suites analytiques et l’expérimentation à grande échelle.

- Zoho PageSense et Adobe Target : ces solutions séduisent par leur capacité à réunir analyse, test et personnalisation dans une même plateforme.

Pour les campagnes Google Ads, il est pertinent de recouper les résultats des tests avec les données de ROAS et de CPA issues de Google Analytics. Les géants de la distribution, d’Amazon à Netflix, s’appuient sur cette approche itérative et méthodique, véritable moteur de leur stratégie marketing. L’écosystème évolue, chaque acteur proposant sa propre vision de l’optimisation de l’expérience utilisateur.

À l’heure où chaque détail compte, le test A/B ne relève plus du gadget technique : c’est la boussole qui oriente les choix et façonne l’avenir du web, un ajustement après l’autre.